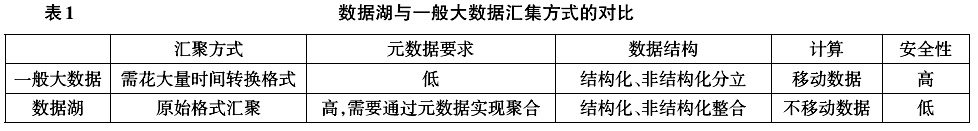

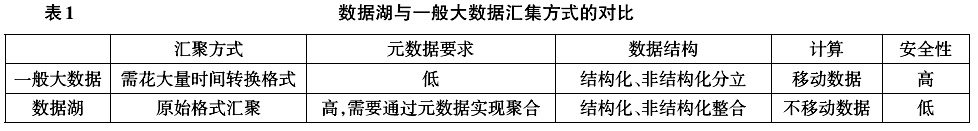

[中图分类号]G434 [文献标识码]A [文章编号]1672-0008(2016)05-0041-09 大数据是近年来快速发展的技术领域。关于大数据的研究与应用与日俱增,并不断深入影响社会生活。购物推荐、路况分析乃至高考预测等与大众密切相关的应用,充分展现了大数据的力量。2016年3月,AlphaGo与李世石的人机大战,让人们从更深层次上认识了大数据驱动下的人工智能对人类社会的深层影响。根据大数据版图(Big Data Landscape)3.0版本的描绘,大数据相关基础设施、分析工具和应用系统都在快速发展中[1]。这个逐年扩展的图景表明了大数据的疆域正在不断延展,领域应用不断深化,影响力与日俱增。 在教育领域中,大数据已经在多方面引起了研究者和实践者的关注。无论是从研究范式、技术应用,还是实践案例都在快速发展之中。教育大数据正在成为教育领域不可忽视的新型驱动力,在教育教学研究与实践中发挥着越来越重要的作用。 作为一个新兴领域,大数据技术仍在快速迭代之中,新方法、新工具和新模式不断涌现。在教育大数据这个细分领域之中,在契合大数据发展整体趋势的同时,具有自身的鲜明特性。在教育大数据日趋瞩目的今天,在研究大数据技术的基础上,分析教育大数据的定义内涵、实践范例、发展趋势与面临挑战,有助于我们把握教育大数据的整体图景,因应技术发展,推动教育的系统化变革。 二、大数据技术的发展趋势 大数据技术的缘起,可以回溯到2004年谷歌公司提出的MapReduce模型[2]。在十几年时间里,大数据技术从概念走向应用,形成了以Hadoop为代表的一整套技术。时至今日,大数据技术仍在快速发展之中,无论是基础框架、分析技术,还是应用系统都在不断演变和完善。据统计,2015年美国大数据初创企业获得的融资额达到了66.4亿美元,占整个技术领域总融资额的11%。这代表着大数据领域具有蓬勃的活力并受到市场的肯定。大数据技术的发展方向是技术发展与应用需求相互推进的结果,对大数据技术趋势的分析,有助于从更本质的层面理解这个领域的现状。 (一)基础架构 历经多年发展,大数据基础设施正在向着快速、便捷与整合的方向发展。Hadoop框架是大数据分析的重要基础框架。但它存在着计算速度慢、运维复杂等问题。基于Hadoop衍生出了如Spark、Pig等框架,正在不断提升计算性能和优化处理流程。与Hadoop相比,Spark的抽象层次更高,计算速度更快,编程更加简便。更重要的是,Spark提供了统一的数据平台,通过不同的模块支持了不同类型的数据应用。通过Spark Core支持批处理,通过Spark SQL支持数据交互,通过Spark Streaming支持流式存储,通过MLlib支持机器学习,通过GrphaX支持图计算[3]。 在大数据基础设施中,各种新技术不断产生,数据湖(Data Lake)和雾计算(Fog Computing)分别从数据的集中与分布的不同角度给出了解决方案。数据湖是大型的基于对象的存储库,数据以其原始格式存储。不需要对数据进行转换,就可以进行全面的监控和分析,并建立数据模型。与一般意义的数据汇聚不同,数据湖不需要改变原始数据的结构,而是支持分析原始数据。这个方式消除了数据抽取、转换和加载ETL的成本。为了达到不改变数据结构直接存储和技术的目标,数据湖对元数据有很高的要求。目前,数据湖技术仍在起步阶段,还存在原始数据差别大、类型复杂、分析应用困难等问题。但它有助于企业完成更长远的数据规划,建立数据治理结构,并预先解决安全问题[4]。数据湖与一般大数据汇集方式的对比,如表1所示。

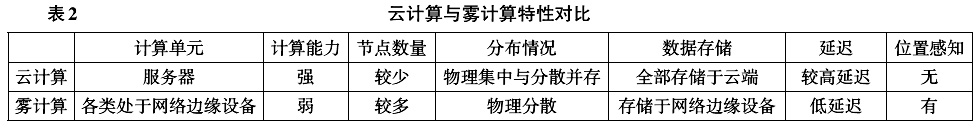

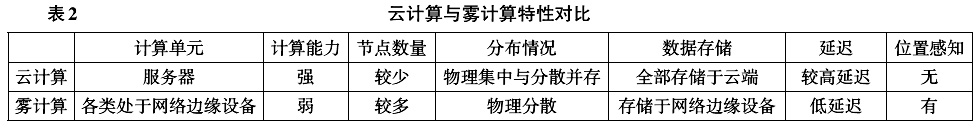

与数据湖侧重数据的聚集不同,雾计算则提出了一种分布式解决方案。雾计算这一名词最早来自网络安全领域,后来由思科(Cisco)公司借用,并赋予了分布式计算的含义。思科将雾解释为“更贴近地面的云”,雾计算是云计算的延伸。与云计算不同,雾计算并非由性能强大的服务器组成,而是由性能较弱、更为分散的各类计算模块和智能网络设置组成,这些低延迟且有能力进行位置感知的模块可以融入各类基础设施,乃至生活用品[5]。 可以预见,随着物联网的不断发展,来自各类终端的数据量会激增。面对这一情况,云计算的瓶颈可能会凸显。在雾计算中,数据、分析和应用都集中在网络的终端节点,只在需要的时候汇集到云中。云计算与雾计算的对比,如表2所示。

雾计算将计算能力延伸到了网络的边缘的各类智能设备。在这种模式下,智能设备的管理与交互就变得非常重要。比如,比特币的底层技术“区块链”(Block Chain)形成了行动登记、权属确认和智能管理模式。这为通过网络实现各种智能终端和设备实现自我管理和智能交互,提供了新的技术支持[6]。 数据湖和雾计算着眼于大数据的源头和终端,从分布和集中两个角度提供了解决方案。诚然,这些方案需要通过实践进行检验。但总体而言,数据湖和雾计算代表着大数据分析基础设施的发展趋势,即采用更灵活的方式获取和处理终端数据,合理分布计算负载,对核心数据进行广泛汇集,通过定制标准实现数据治理。

与数据湖侧重数据的聚集不同,雾计算则提出了一种分布式解决方案。雾计算这一名词最早来自网络安全领域,后来由思科(Cisco)公司借用,并赋予了分布式计算的含义。思科将雾解释为“更贴近地面的云”,雾计算是云计算的延伸。与云计算不同,雾计算并非由性能强大的服务器组成,而是由性能较弱、更为分散的各类计算模块和智能网络设置组成,这些低延迟且有能力进行位置感知的模块可以融入各类基础设施,乃至生活用品[5]。 可以预见,随着物联网的不断发展,来自各类终端的数据量会激增。面对这一情况,云计算的瓶颈可能会凸显。在雾计算中,数据、分析和应用都集中在网络的终端节点,只在需要的时候汇集到云中。云计算与雾计算的对比,如表2所示。

与数据湖侧重数据的聚集不同,雾计算则提出了一种分布式解决方案。雾计算这一名词最早来自网络安全领域,后来由思科(Cisco)公司借用,并赋予了分布式计算的含义。思科将雾解释为“更贴近地面的云”,雾计算是云计算的延伸。与云计算不同,雾计算并非由性能强大的服务器组成,而是由性能较弱、更为分散的各类计算模块和智能网络设置组成,这些低延迟且有能力进行位置感知的模块可以融入各类基础设施,乃至生活用品[5]。 可以预见,随着物联网的不断发展,来自各类终端的数据量会激增。面对这一情况,云计算的瓶颈可能会凸显。在雾计算中,数据、分析和应用都集中在网络的终端节点,只在需要的时候汇集到云中。云计算与雾计算的对比,如表2所示。  雾计算将计算能力延伸到了网络的边缘的各类智能设备。在这种模式下,智能设备的管理与交互就变得非常重要。比如,比特币的底层技术“区块链”(Block Chain)形成了行动登记、权属确认和智能管理模式。这为通过网络实现各种智能终端和设备实现自我管理和智能交互,提供了新的技术支持[6]。 数据湖和雾计算着眼于大数据的源头和终端,从分布和集中两个角度提供了解决方案。诚然,这些方案需要通过实践进行检验。但总体而言,数据湖和雾计算代表着大数据分析基础设施的发展趋势,即采用更灵活的方式获取和处理终端数据,合理分布计算负载,对核心数据进行广泛汇集,通过定制标准实现数据治理。

雾计算将计算能力延伸到了网络的边缘的各类智能设备。在这种模式下,智能设备的管理与交互就变得非常重要。比如,比特币的底层技术“区块链”(Block Chain)形成了行动登记、权属确认和智能管理模式。这为通过网络实现各种智能终端和设备实现自我管理和智能交互,提供了新的技术支持[6]。 数据湖和雾计算着眼于大数据的源头和终端,从分布和集中两个角度提供了解决方案。诚然,这些方案需要通过实践进行检验。但总体而言,数据湖和雾计算代表着大数据分析基础设施的发展趋势,即采用更灵活的方式获取和处理终端数据,合理分布计算负载,对核心数据进行广泛汇集,通过定制标准实现数据治理。